Основи на инженерството на данни – изграждане на ефективни и мащабируеми решения

Въведение

В ерата на дигиталната трансформация данните се превърнаха в един от най-ценните ресурси за бизнеса. Организациите разполагат с огромни количества информация, но без правилните инструменти и подходи за обработка, тези данни остават неструктурирани и неизползваеми. Тук идва ролята на инженерството на данни – ключова дисциплина, която позволява на компаниите да извличат стойност от информацията, да подобряват операциите си и да вземат по-информирани решения.

Компаниите днес генерират и обработват огромни обеми от данни – от клиентски транзакции и производствени процеси до маркетингови кампании и анализ на потребителското поведение. Инженерството на данни осигурява инфраструктурата и процесите, необходими за събиране, съхранение и обработка на тези данни.

Сред основните приложения на инженерството на данни в бизнеса са:

- Оптимизация на операциите – Чрез анализ на данните компаниите могат да подобрят производствените си процеси, да автоматизират задачи и да намалят разходите.

- По-добро обслужване на клиенти – Данните позволяват на фирмите да персонализират услугите си, да предвиждат нуждите на клиентите и да предлагат по-качествено потребителско изживяване.

- Подобрено вземане на решения – Достъпът до добре структурирани и анализирани данни помага на ръководителите да правят информирани стратегически избори.

- Автоматизация и предиктивен анализ – Използването на алгоритми и машинно обучение позволява прогнозиране на тенденции и автоматично оптимизиране на бизнес процеси.

За да може инженерството на данни да бъде ефективно приложено, е необходимо използването на разнообразни технологии и методологии, които гарантират ефективност, точност и сигурност при обработката на информация.

В тази статия ще се фокусираме върху ключовите аспекти на инженерството на данни, необходими за създаването на стабилни и ефективни решения за обработка и управление на информацията. Сред тях са:

- SQL – езикът на базите данни: Ще разгледаме как SQL се използва за извличане и манипулиране на информация в релационни бази данни, както и стратегии за оптимизация на заявки.

- Python за инженери на данни: Един от най-използваните програмни езици за обработка на данни и автоматизация на процеси. Ще обърнем внимание на неговите библиотеки и приложения в ETL (Extract, Transform, Load) процеси.

- Apache Airflow – управление на работни процеси: Ще обсъдим как този инструмент улеснява оркестрацията на сложни процеси по обработка на данни и как може да бъде внедрен в корпоративна среда.

- Складове за данни (Data Warehouses): Ще представим концепцията за складове за данни, тяхното значение за бизнеса и как могат да бъдат изградени ефективно.

- Управление на данните (Data Governance): Ще разгледаме добрите практики за осигуряване на качество, сигурност и достъпност на информацията в една организация.

Инженерството на данни е основата, върху която бизнесът изгражда своите аналитични и стратегически решения. В следващите раздели ще навлезем в детайли за всяка от тези ключови технологии и ще покажем как те могат да бъдат приложени за постигане на по-добри бизнес резултати.

1. Основи на инженерството на данни

В ерата на дигитализацията организациите разполагат с огромни обеми от данни, но тяхната стойност зависи от способността да бъдат структурирани, обработени и анализирани ефективно. Тук идва ролята на инженерството на данни – дисциплина, която осигурява необходимата инфраструктура и процеси за управление на данните.

Какво представлява инженерството на данни и защо е критично за бизнеса

Инженерството на данни (Data Engineering) е област, която се фокусира върху изграждането и поддръжката на системи за събиране, съхранение и обработка на информация. То осигурява основата, върху която работят анализаторите на данни, специалистите по машинно обучение и бизнес ръководителите, като им предоставя точни и добре структурирани данни.

Защо инженерството на данни е от критично значение?

- Осигурява надеждна инфраструктура – Компаниите разчитат на стабилни и мащабируеми системи за обработка на данни, които да поддържат бързи и ефективни бизнес операции.

- Подобрява качеството на данните – Добре изградени процеси гарантират чистота, точност и последователност на информацията, намалявайки риска от грешки в анализа.

- Улеснява автоматизацията и интеграцията – Инженерството на данни позволява интегриране на различни източници на информация и автоматизация на рутинни процеси.

- Подпомага вземането на стратегически решения – Фирмите, които използват добре структурирани данни, могат да реагират по-бързо на пазарни промени и да изграждат по-успешни стратегии.

Разликата между анализ на данни (data analytics) и инженерство на данни (data engineering)

Макар често да се използват заедно, инженерството на данни и анализът на данни изпълняват различни роли:

|

Характеристика |

Инженерство на данни (Data Engineering) |

Анализ на данни (Data Analytics) |

|---|---|---|

|

Цел |

Изграждане на инфраструктура за управление и обработка на данни. |

Извличане на полезни прозрения от вече обработените данни. |

|

Фокус |

Събиране, съхранение, трансформиране и управление на данните. |

Анализиране, визуализиране и интерпретиране на данни. |

|

Инструменти |

SQL, Python, Apache Airflow, Hadoop, ETL платформи. |

Tableau, Power BI, Python, Excel, статистически модели. |

|

Роля в бизнеса |

Гарантира, че данните са точни, налични и добре структурирани. |

Подпомага вземането на информирани решения чрез анализ на тенденции и прогнози. |

В най-опростената си форма инженерството на данни създава „магистралите“, по които се движат данните, а анализът на данни използва тези „магистрали“, за да извлече полезна информация за бизнеса.

Основни принципи при изграждането на мащабируеми и ефективни системи за обработка на данни

За да бъде ефективно, инженерството на данни трябва да следва няколко основни принципа:

- Мащабируемост (Scalability) – Системите трябва да бъдат проектирани така, че да могат да обработват нарастващи обеми от данни без загуба на производителност. Това включва използване на разпределени изчисления и cloud-базирани решения.

- Надеждност (Reliability) – Инженерните процеси трябва да осигуряват точност и пълнота на данните, като се използват техники за валидиране и мониторинг на качеството.

- Автоматизация (Automation) – Изграждането на автоматизирани ETL (Extract, Transform, Load) процеси минимизира ръчните операции и намалява риска от човешки грешки.

- Оптимизация на производителността (Performance Optimization) – Бързият достъп до данни е от съществено значение, затова се използват индексиране, кеширане и компресиране на информацията.

- Сигурност и управление на достъпа (Security & Access Management) – Данните трябва да бъдат защитени чрез механизми като криптиране, ролеви базиран контрол на достъпа (RBAC) и регулаторно съответствие.

- Гъвкавост и интеграция (Flexibility & Integration) – Системите трябва да могат лесно да се свързват с различни платформи и технологии, позволявайки интеграция между бази данни, облачни решения и BI инструменти.

Пример за успешно прилагане на тези принципи е изграждането на централизирана cloud-базирана инфраструктура за данни, която осигурява достъп в реално време до надеждна информация за вземане на стратегически решения.

Инженерството на данни е основен елемент от дигиталната трансформация на бизнеса. То осигурява инфраструктурата, която прави възможни анализите, прогнозите и автоматизацията, необходими за стратегическото развитие на компаниите. В следващия раздел ще разгледаме как SQL се използва като основен инструмент за управление и обработка на данни в корпоративна среда.

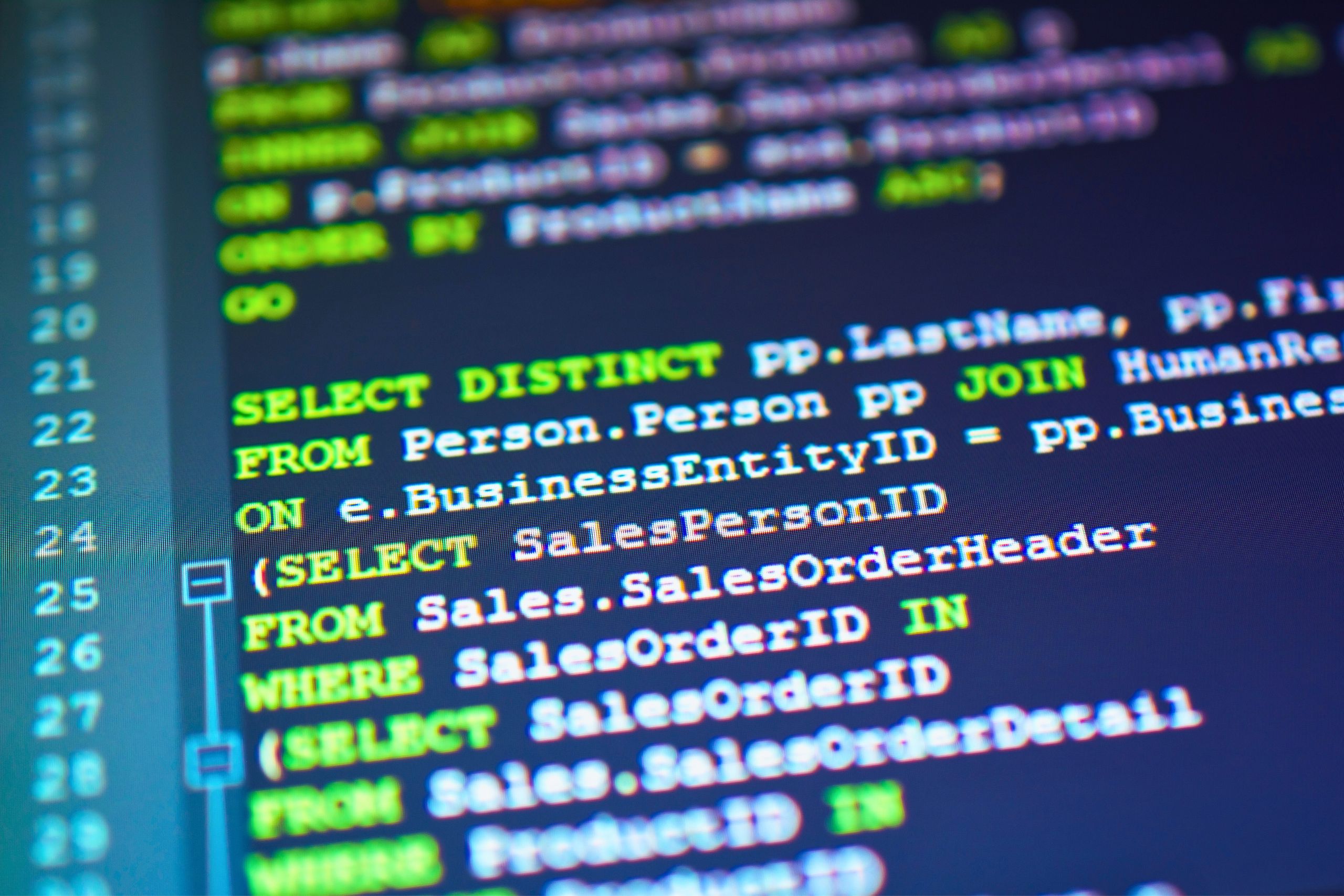

2. Работа със SQL – основни концепции и добри практики

SQL (Structured Query Language) е основен инструмент за управление и манипулиране на данни в релационни бази. В инженерството на данни той играе критична роля, като позволява ефективно съхранение, извличане, трансформиране и анализ на големи масиви от информация. Компаниите разчитат на SQL за управление на своите бизнес процеси, анализиране на клиентско поведение и оптимизиране на оперативната ефективност.

Как SQL се използва за извличане и манипулиране на данни в релационни бази

Релационните бази данни (RDBMS) като MySQL, PostgreSQL, Microsoft SQL Server и Oracle са широко използвани за съхранение на бизнес информация. SQL е езикът, който позволява взаимодействие с тези системи чрез заявки за създаване, извличане, актуализиране и изтриване на данни.

Основните функционалности на SQL включват:

- Извличане на информация – Използване на SELECT за получаване на специфични данни от базата.

- Филтриране на резултати – Приложение на WHERE, HAVING и LIMIT за ограничаване на върнатите записи.

- Групиране на данни – Използване на GROUP BY и агрегатни функции като COUNT(), SUM(), AVG().

- Свързване на таблици – Обединяване на информация от различни източници чрез JOIN операции.

- Манипулиране на данни – Използване на INSERT, UPDATE, DELETE за промяна на информацията в базата.

В ежедневната бизнес практика SQL се използва за всичко – от генериране на финансови отчети до анализ на поведението на клиентите и прогнозиране на продажбите.

Важни SQL заявки: селектиране, филтриране, групиране и обединяване на данни

- Извличане на данни (SELECT)

SELECT first_name, last_name, email FROM customers;- Тази заявка връща списък с клиенти и техните имейли от таблицата customers.

- Филтриране на данни (WHERE)

SELECT * FROM orders WHERE order_date >= '2024-01-01';- Тук се извличат всички поръчки, направени след началото на 2024 година.

- Групиране на информация (GROUP BY)

SELECT product_id, COUNT(*) AS total_sales

FROM orders

GROUP BY product_id

HAVING COUNT(*) > 10;- Тази заявка показва броя на поръчките за всеки продукт, като оставя само тези с повече от 10 продажби.

- Свързване на таблици (JOIN)

SELECT customers.first_name, customers.last_name, orders.order_id

FROM customers

INNER JOIN orders ON customers.customer_id = orders.customer_id;- Чрез JOIN операторите се комбинират клиентите и техните поръчки, за да се получи по-пълна информация за направените покупки.

Оптимизация на SQL заявки за подобряване на производителността

С увеличаването на обема на данните ефективността на SQL заявките става критично важна. Бавните заявки могат да забавят процесите и да натоварят сървърите. За подобряване на производителността се използват следните техники:

- Индексиране (INDEX) – Създаването на индекси върху често използвани колони ускорява търсенето на записи.

CREATE INDEX idx_customer_email ON customers(email);- Ограничаване на върнатите данни – Използването на LIMIT при големи набори от данни намалява времето за изпълнение.

SELECT * FROM transactions ORDER BY transaction_date DESC LIMIT 100;- Избягване на излишни SELECT * заявки – Извличането само на необходимите колони вместо всички намалява натоварването на системата.

- Използване на EXPLAIN за анализ на заявки – Позволява разбиране на начина, по който база данни изпълнява заявките и идентифициране на потенциални проблеми.

EXPLAIN SELECT * FROM orders WHERE customer_id = 123;- Оптимизация чрез партиционни таблици (Partitioning) – Разделяне на големи таблици на логически по-малки части, което подобрява скоростта на достъп.

Пример за работа със SQL в бизнес среда – анализ на клиенти и транзакции

Да разгледаме сценарий, в който мениджър на електронен магазин иска да анализира поведението на клиентите и техните покупки.

Сценарий:

Фирмата иска да разбере кои клиенти са най-активни през последния месец и какъв е средният размер на техните поръчки.

SQL заявка за анализ:

SELECT customers.customer_id, customers.first_name, customers.last_name,

COUNT(orders.order_id) AS total_orders,

AVG(orders.total_amount) AS avg_order_value

FROM customers

LEFT JOIN orders ON customers.customer_id = orders.customer_id

WHERE orders.order_date >= '2024-01-01'

GROUP BY customers.customer_id, customers.first_name, customers.last_name

ORDER BY total_orders DESC;Резултат:

- total_orders показва броя на направените поръчки от всеки клиент.

- avg_order_value изчислява средната стойност на поръчките.

- Резултатите са подредени, така че най-активните клиенти са на първите места.

Този тип анализ позволява на бизнеса да идентифицира ключови клиенти, да персонализира офертите си и да подобри маркетинговите си стратегии.

SQL е основополагащ инструмент за инженерството на данни, който позволява ефективно управление и обработка на информация в релационни бази. Независимо дали става въпрос за селектиране, филтриране, групиране или свързване на данни, използването на оптимизирани SQL заявки е от решаващо значение за постигане на висока производителност.

В следващата част ще разгледаме как Python допълва инженерството на данни, като осигурява мощни инструменти за автоматизация и обработка на информация.

3. Python за инженери на данни – автоматизация и обработка на информация

Python е един от най-популярните езици за програмиране в областта на инженерството на данни. Гъвкавостта, мощните библиотеки и лесният синтаксис го правят предпочитан инструмент за обработка, трансформация и анализ на големи обеми информация. В съвременния бизнес Python се използва за автоматизиране на рутинни задачи, оптимизиране на ETL (Extract, Transform, Load) процеси и интегриране на различни системи за управление на данни.

Как Python се използва за обработка, трансформация и анализ на данни

В инженерството на данни обработката на информация е критичен процес, който включва:

- Извличане на данни от различни източници – Python позволява връзка с релационни бази данни (SQL), NoSQL хранилища, API-та и файлови системи (CSV, JSON, XML).

- Трансформация и почистване на данни – Голяма част от работата на инженерите на данни е свързана с премахване на дублиращи се записи, обработка на липсващи стойности и конвертиране на данните в унифициран формат.

- Анализ и визуализация – Чрез Python може да се идентифицират тенденции, да се моделират зависимости и да се представят данни в графична форма.

Пример за обработка на CSV файл с Python:

import pandas as pd

# Зареждане на данни от CSV файл

df = pd.read_csv("sales_data.csv")

# Премахване на липсващи стойности

df.dropna(inplace=True)

# Конвертиране на дата колоната в правилен формат

df['date'] = pd.to_datetime(df['date'])

# Филтриране на продажбите за последния месец

recent_sales = df[df['date'] >= "2024-01-01"]

print(recent_sales.head())Този код автоматично обработва, почиства и структурира данните, готови за анализ или зареждане в база данни.

Основни библиотеки за инженерството на данни: Pandas, NumPy и SQLAlchemy

Python разполага с множество библиотеки, които улесняват обработката на данни. Най-важните от тях включват:

- Pandas – Основна библиотека за работа с таблични данни, която позволява четене, трансформация и анализ.

- NumPy – Мощен инструмент за работа с многомерни масиви и математически операции, използван за бързи изчисления.

- SQLAlchemy – Библиотека за работа с релационни бази данни чрез Python, която позволява създаване, модифициране и извличане на информация от SQL бази.

Пример за използване на SQLAlchemy за достъп до база данни:

from sqlalchemy import create_engine

import pandas as pd

# Свързване с база данни

engine = create_engine("sqlite:///company.db")

# Извличане на данни с SQL заявка

query = "SELECT * FROM employees WHERE department = 'Sales'"

df = pd.read_sql(query, engine)

print(df.head())Тази гъвкавост позволява на инженерите на данни бързо да интегрират различни източници на информация и да ги обработват ефективно.

Автоматизиране на ETL (Extract, Transform, Load) процеси с Python

ETL (Extract, Transform, Load) процесите са в основата на инженерството на данни. Python се използва за автоматизиране на тези стъпки, като извлича данни от различни източници, трансформира ги в подходящ формат и ги зарежда в база данни или хранилище.

Пример за ETL процес с Python:

import pandas as pd

from sqlalchemy import create_engine

# Извличане на данни от CSV файл

df = pd.read_csv("customer_data.csv")

# Трансформация: коригиране на имената на колоните и форматиране на данните

df.rename(columns={"CustomerID": "customer_id", "AmountSpent": "amount_spent"}, inplace=True)

df["amount_spent"] = df["amount_spent"].astype(float)

# Зареждане в база данни

engine = create_engine("sqlite:///sales.db")

df.to_sql("customers", con=engine, if_exists="replace", index=False)

print("ETL процесът е завършен успешно.")Тази автоматизация намалява нуждата от ръчно обработване и осигурява надеждна трансформация на данни с минимален риск от грешки.

Пример за автоматизирана обработка на данни чрез Python скриптове

Да разгледаме реален сценарий, в който фирма за онлайн търговия иска ежедневно да анализира продажбите си и да идентифицира най-продаваните продукти.

Сценарий:

- Източникът на данни е MySQL база данни с поръчки.

- Необходимо е автоматично извличане на данните, обработка и записване на обобщени резултати в нова таблица.

Python решение:

import pandas as pd

from sqlalchemy import create_engine

# Свързване с MySQL база данни

engine = create_engine("mysql+pymysql://user:password@localhost/sales_db")

# Извличане на последните поръчки

query = "SELECT product_id, COUNT(*) AS total_sales FROM orders WHERE order_date >= CURDATE() - INTERVAL 30 DAY GROUP BY product_id"

df = pd.read_sql(query, engine)

# Зареждане на обработените данни в нова таблица

df.to_sql("monthly_sales_summary", con=engine, if_exists="replace", index=False)

print("Обобщените данни за продажбите са успешно актуализирани.")Този скрипт автоматично събира, обработва и записва информацията, като осигурява актуални данни за анализ на мениджърите и търговските екипи.

Python е незаменим инструмент за инженерите на данни, който осигурява мощни възможности за обработка, трансформация и анализ на информация. Благодарение на богатата екосистема от библиотеки като Pandas, NumPy и SQLAlchemy, той улеснява автоматизирането на ETL процесите и интегрирането на различни източници на данни.

В следващата част ще разгледаме Apache Airflow – мощен инструмент за оркестрация на работни процеси, който позволява автоматизиране на сложни ETL процеси и ефективно управление на потока от данни.

4. Apache Airflow – оркестрация на работни процеси

В съвременния свят на инженерството на данни, ефективното управление и автоматизация на работните процеси е от съществено значение. Apache Airflow е един от най-мощните инструменти за оркестрация на ETL (Extract, Transform, Load) процеси, осигуряващ възможност за планиране, изпълнение и мониторинг на сложни задачи за обработка на данни.

Какво представлява Apache Airflow и защо е ключов инструмент за инженерите на данни

Apache Airflow е платформа с отворен код за създаване, управление и автоматизация на работни процеси (workflows). Разработен от Airbnb, той се използва широко от компании по целия свят за координиране на ETL процеси, интеграция на данни и управление на мащабни изчислителни задачи.

Защо инженерите на данни разчитат на Apache Airflow?

- Гъвкавост – Поддържа работа с различни източници на данни и услуги, като бази данни, облачни платформи и API-та.

- Автоматизация – Намалява ръчната работа чрез планиране и изпълнение на работни процеси в точно определено време.

- Мащабируемост – Подходящ както за малки, така и за големи организации с милиони трансакции дневно.

- Проследимост и контрол – Осигурява възможност за мониторинг и дебъгване на всеки етап от обработката на данните.

Airflow позволява на инженерите на данни да дефинират и управляват ETL процесите чрез интуитивни Python скриптове, вместо чрез сложни конфигурационни файлове.

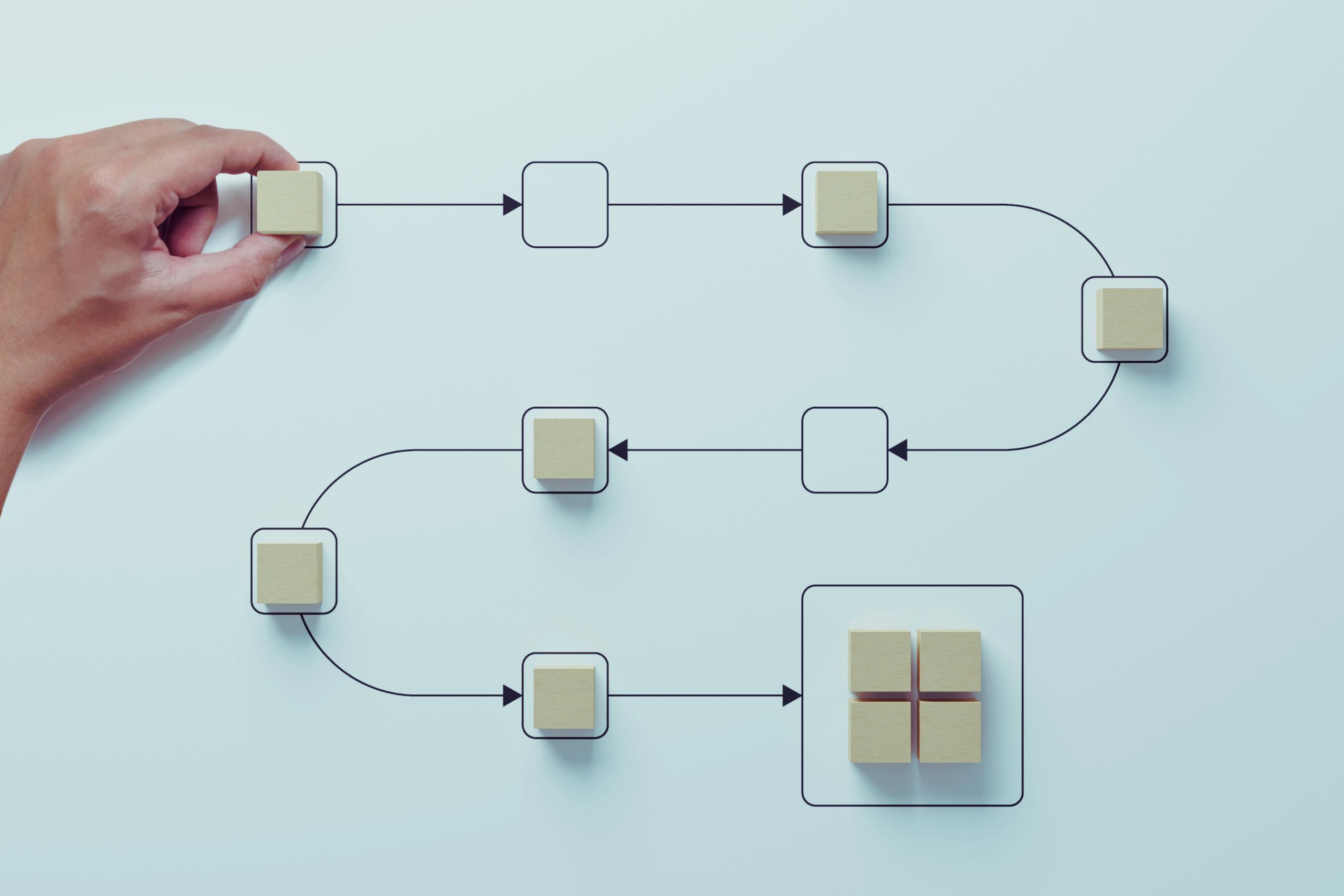

Основни концепции: DAGs (Directed Acyclic Graphs), оператори, задачи и зависимости

Apache Airflow използва концепцията за DAG (Directed Acyclic Graph) – структуриран работен процес, състоящ се от отделни задачи, които се изпълняват в предварително дефиниран ред.

Основни елементи на Apache Airflow:

- DAG (Directed Acyclic Graph) – Представя целия работен процес като зависимост между задачи. Всяка задача се изпълнява последователно или паралелно според зададените зависимости.

- Оператори (Operators) – Действията, които трябва да се изпълнят в рамките на DAG. Например, извличане на данни от база, трансформиране на файлове или изпращане на резултатите към друга система.

- Задачи (Tasks) – Конкретни операции в рамките на DAG, които могат да бъдат изпълнени самостоятелно или във връзка с други задачи.

- Зависимости (Dependencies) – Определят реда, по който задачите се изпълняват, като гарантират правилното протичане на процеса.

Пример за DAG с три задачи:

[Извличане на данни] → [Трансформиране на данни] → [Зареждане на резултатите в база]Това осигурява ясен и предсказуем поток на работа, минимизирайки риска от грешки при обработката на данни.

Как Airflow автоматизира ETL процеси и подобрява ефективността на данните

Apache Airflow значително подобрява ETL процесите, като осигурява:

- Планиране и изпълнение – Airflow позволява планиране на задачи в предварително зададени интервали (например, ежедневно извличане на финансови отчети).

- Управление на грешки – Ако дадена задача се провали, системата може автоматично да я рестартира или да изпрати известие за проблема.

- Интеграция с други технологии – Работи съвместно с инструменти като AWS, Google Cloud, PostgreSQL, Spark и други платформи за обработка на данни.

- Визуализация и мониторинг – Графичният интерфейс на Airflow предоставя в реално време информация за състоянието на задачите и възможност за намеса при нужда.

Примерен сценарий:

Компания използва Apache Airflow за автоматизирано ежедневно зареждане на клиентски данни от облачна CRM система в база данни, като преди това информацията преминава през процеси за трансформация и валидация.

Пример за изграждане на работен процес с Apache Airflow

Следният код показва как може да се създаде ETL процес в Apache Airflow, който автоматично извлича данни, трансформира ги и ги записва в база:

from airflow import DAG

from airflow.operators.python import PythonOperator

from datetime import datetime

import pandas as pd

import sqlite3

# Функции за извличане, трансформиране и зареждане

def extract_data():

data = {"customer_id": [1, 2, 3], "purchase": [100, 200, 150]}

df = pd.DataFrame(data)

df.to_csv("/tmp/data.csv", index=False)

def transform_data():

df = pd.read_csv("/tmp/data.csv")

df["purchase"] = df["purchase"] * 1.2 # Добавяне на 20% ДДС

df.to_csv("/tmp/transformed_data.csv", index=False)

def load_data():

df = pd.read_csv("/tmp/transformed_data.csv")

conn = sqlite3.connect("/tmp/sales.db")

df.to_sql("sales", conn, if_exists="replace", index=False)

conn.close()

# Дефиниране на DAG

default_args = {

"start_date": datetime(2024, 1, 1),

"catchup": False,

}

dag = DAG("etl_process", default_args=default_args, schedule_interval="@daily")

# Определяне на задачи

extract_task = PythonOperator(task_id="extract", python_callable=extract_data, dag=dag)

transform_task = PythonOperator(task_id="transform", python_callable=transform_data, dag=dag)

load_task = PythonOperator(task_id="load", python_callable=load_data, dag=dag)

# Определяне на зависимостите между задачите

extract_task >> transform_task >> load_taskОбяснение на кода:

- Извличане на данни – Генерира се примерен CSV файл със стойности за клиенти.

- Трансформация – Добавя се 20% ДДС към всички покупки.

- Зареждане – Обработените данни се записват в SQLite база данни.

- Организация на процеса – DAG дефинира последователността на задачите и ги планира за автоматично изпълнение всеки ден.

Apache Airflow е мощен инструмент, който улеснява автоматизацията на сложни ETL процеси и осигурява гъвкавост при управлението на работните потоци. Благодарение на своите концепции за DAGs, оператори и задачи, той позволява надеждно планиране и изпълнение на процеси за обработка на данни.

В следващата част ще разгледаме концепцията за складове за данни (Data Warehouses) и как те се използват за съхранение и анализ на големи масиви информация.

5. Складове за данни – изграждане на мащабируеми решения

Складовете за данни (Data Warehouses) са специализирани системи за съхранение и анализ на големи обеми структурирани данни. Те се използват в организациите за интегриране на данни от различни източници, улесняване на бизнес анализа и подпомагане на вземането на стратегически решения. В сравнение с традиционните бази данни, складовете за данни са оптимизирани за бързо извличане на информация, дългосрочно съхранение и сложни аналитични процеси.

Какво е склад за данни и как се различава от обикновените бази данни

Докато релационните бази данни (RDBMS) като MySQL, PostgreSQL и SQL Server се използват за оперативни задачи (като съхранение на текущи транзакции и потребителски данни), складовете за данни са предназначени за анализ и вземане на решения.

Основни разлики между склад за данни и релационна база данни:

|

Характеристика |

Релационна база данни (OLTP) |

Склад за данни (OLAP) |

|---|---|---|

|

Основна цел |

Управление на транзакции |

Анализ и отчетност |

|

Обем на данните |

Малък до среден |

Голям |

|

Честота на актуализации |

Чести |

По-редки, пакетни |

|

Вид на заявките |

Кратки и чести |

Дълги и сложни анализи |

|

Оптимизация |

Бързи записвания |

Бързо извличане на данни |

Складовете за данни съхраняват исторически данни, което ги прави мощен инструмент за разкриване на дългосрочни бизнес тенденции и модели.

Основни компоненти и архитектури на съвременните складове за данни

Съвременните складове за данни се състоят от няколко ключови компонента, които осигуряват ефективно съхранение, обработка и анализ на информацията:

- Източници на данни (Data Sources) – Информацията идва от различни вътрешни и външни системи като CRM, ERP, уебсайтове, IoT устройства и др.

- ETL/ELT процеси (Extract, Transform, Load) – Инструменти като Apache Airflow, Talend и dbt извличат, трансформират и зареждат данните в склада.

- Хранилище за данни (Data Warehouse Storage) – Това е мястото, където обработените данни се съхраняват. Популярни решения са Amazon Redshift, Google BigQuery и Snowflake.

- Метаданни (Metadata Management) – Дефинира структурата и произхода на данните, което улеснява тяхното управление и използване.

- BI и анализ (Business Intelligence & Analytics) – Инструменти като Tableau, Power BI и Looker се използват за визуализация и анализ на съхранената информация.

Архитектури на складове за данни:

- Еднослойна архитектура – Всички данни се съхраняват на едно място и се извличат директно. Подходяща за малки организации.

- Двуслойна архитектура – Включва етап за обработка и почистване на данните, преди те да бъдат заредени в склада.

- Трислойна архитектура – Най-често срещаният модел, включващ:

- Оперативни данни (Staging Layer) – Сурови данни, подготвени за трансформация.

- Интеграционен слой (Data Warehouse Layer) – Структурирани и агрегирани данни.

- Представителен слой (Data Mart Layer) – Оптимизирани набори от данни за конкретни бизнес нужди.

Пример за изграждане на склад за данни с цел бизнес анализ

Да разгледаме сценарий, в който фирма за онлайн търговия иска да създаде склад за данни, за да анализира клиентските си покупки и да подобри маркетинговите си стратегии.

Стъпки за изграждане на склада за данни:

- Извличане на данни – Данни за поръчки, продукти и клиенти се събират от SQL база, API и CSV файлове.

- Трансформация – Данните се почистват, дублиращите се записи се премахват, а категориите се стандартизират.

- Зареждане в склада – Информацията се записва в Google BigQuery или Snowflake за анализ.

- Създаване на BI отчети – Power BI и Tableau се използват за визуализация на тенденциите в продажбите.

Примерен SQL код за анализ на клиентски поръчки:

SELECT customer_id, COUNT(order_id) AS total_orders, SUM(order_amount) AS total_spent

FROM orders

WHERE order_date >= '2024-01-01'

GROUP BY customer_id

ORDER BY total_spent DESC

LIMIT 10;Тази заявка показва най-ценните клиенти на бизнеса, което може да помогне за персонализирани маркетингови кампании.

Складовете за данни играят критична роля в управлението и анализа на големи обеми информация. Те позволяват на компаниите да интегрират и анализират данни от различни източници, за да вземат информирани бизнес решения.

В следващата част ще разгледаме концепцията за управление на данни (Data Governance) и как организациите гарантират качеството, сигурността и спазването на регулаторните изисквания при работата с информация.

6. Управление на данните (Data Governance) – гарантиране на сигурност и качество

В съвременния бизнес данните са стратегически актив, който може да определи успеха или провала на една организация. Управлението на данните (Data Governance) включва политики, процеси и технологии, които осигуряват качеството, сигурността и достъпността на информацията. Ефективното управление на данните гарантира, че организациите могат да използват информацията си надеждно, спазвайки регулаторните изисквания и минимизирайки рисковете от загуба, неправилна интерпретация или злоупотреба с данни.

Какво е управление на данните и защо е критично за организациите

Data Governance е систематичен подход за управление на информацията в рамките на една организация. Той обхваща стратегии за контрол, стандартизация и сигурност на данните, за да гарантира, че те са точни, последователни и достъпни за правилните хора в правилния момент.

Основни причини, поради които управлението на данните е от съществено значение:

- Гарантиране на качеството на данните – Неточни, дублирани или непълни данни могат да доведат до грешки при анализите и вземането на решения.

- Съответствие с регулаторните изисквания – GDPR, HIPAA, SOX и други нормативни актове изискват строги мерки за защита и управление на данните.

- Оптимизиране на оперативните процеси – Добре структурираното управление на данните намалява времето за обработка и подобрява ефективността на бизнеса.

- Подобряване на сигурността на информацията – Избягване на нерегламентиран достъп и потенциални кибератаки чрез прилагане на политики за защита на данните.

Пример: Финансова институция, която съхранява данни за клиенти, трябва да има строги правила за контрол върху достъпа до чувствителна информация, за да гарантира нейната поверителност и да спазва регулаторните изисквания.

Основни принципи на Data Governance: качество на данните, сигурност и достъпност

Управлението на данните се основава на три ключови принципа:

1. Качество на данните (Data Quality)

Гарантирането на точност, последователност и актуалност на информацията е критично за ефективността на бизнес операциите. Основните аспекти на качеството на данните включват:

- Точност – Данните трябва да отразяват реалната ситуация.

- Цялостност – Не трябва да липсват ключови стойности или полета.

- Последователност – Различните системи трябва да съхраняват еднакви данни без противоречия.

- Актуалност – Информацията трябва да се обновява своевременно, за да е релевантна.

2. Сигурност на данните (Data Security)

Сигурността на данните включва мерки за защита от неоторизиран достъп, загуба или манипулация. Основните стратегии за защита включват:

- Контрол на достъпа – Разграничаване на потребителските права за четене, модифициране и изтриване на данни.

- Шифроване – Криптиране на данни, за да се предотврати тяхното неправомерно използване.

- Мониторинг и одит – Проследяване на действията, извършвани с данните, за да се идентифицират потенциални нарушения.

Пример: Банкова институция може да използва двуфакторна автентикация и криптирани бази данни, за да защити финансова информация.

3. Достъпност на данните (Data Accessibility)

Осигуряването на достъп до информацията за правилните потребители е също толкова важно, колкото и защитата ѝ. Основни аспекти тук са:

- Ролева идентификация – Определяне на кои служители трябва да имат достъп до конкретни типове данни.

- Документиране на метаданни – Поддържане на информация за структурата и значението на данните.

- Автоматизиране на управлението на достъпа – Инструменти за регулиране на правата спрямо позицията и отговорностите на служителите.

Пример: В производствена компания, инженерите може да имат достъп до данни за материали, но не и до финансовите отчети.

Инструменти и добри практики за управление на данните в корпоративна среда

Успешното управление на данните изисква използването на правилните инструменти и прилагане на добри практики.

Популярни инструменти за Data Governance:

- Collibra – Платформа за управление на данни, осигуряваща цялостна стратегия за Data Governance.

- Informatica Data Governance – Решение за контрол на качеството на данните, съответствие и сигурност.

- IBM InfoSphere Information Governance Catalog – Инструмент за каталогизиране и управление на корпоративни данни.

- Microsoft Purview – Облачна платформа за управление на метаданни и осигуряване на сигурност.

Добрите практики в управлението на данни включват:

- Създаване на политики за Data Governance – Всяка организация трябва да има дефинирани правила за обработка и съхранение на данни.

- Обучение на персонала – Служителите трябва да разбират важността на защитата на данните и да следват установените стандарти.

- Редовен одит и контрол – Организациите трябва периодично да анализират качеството на данните и тяхната сигурност.

- Използване на автоматизирани инструменти – Инструментите за мониторинг и контрол на данните значително намаляват човешките грешки и увеличават ефективността.

Пример: Голяма технологична компания прилага политика за управление на данните, която включва редовни проверки на качеството на информацията и автоматизирани механизми за контрол на достъпа.

Управлението на данните е критичен процес за всяка модерна организация, която иска да осигури качество, сигурност и ефективно използване на информацията си. Чрез прилагане на добри практики, използване на правилните инструменти и изграждане на ясна стратегия, компаниите могат да минимизират рисковете и да извлекат максимална стойност от своите данни.

В следващата част ще направим обобщение на всички разгледани аспекти на инженерството на данни и ще подчертаем ключовите изводи за успешното му прилагане в бизнеса.

7. Практически стъпки за успешна стратегия за инженерство на данни

Инженерството на данни е динамична област, в която правилният избор на технологии и подходи може значително да повиши ефективността на работата с данни. Успешната стратегия за инженерство на данни изисква внимателен подбор на инструменти, автоматизация на процесите и интеграция между различни системи. В този раздел ще разгледаме ключовите стъпки, които организациите могат да предприемат, за да изградят надеждна и мащабируема инфраструктура за обработка на данни.

Как да се избере правилният технологичен стек за обработка на данни

Изборът на технологичен стек за инженерство на данни зависи от няколко ключови фактора: обем на данните, честота на обработката, сложност на ETL процесите и нуждите от анализ. Организациите трябва да вземат предвид следните аспекти:

- Типове бази данни:

- Релационни бази данни (SQL): PostgreSQL, MySQL, Microsoft SQL Server – подходящи за транзакционни операции и структурирани данни.

- NoSQL бази: MongoDB, Cassandra – добри за съхранение на неструктурирани данни и високо мащабируеми приложения.

- Облачни решения: Google BigQuery, Amazon Redshift, Snowflake – предназначени за складове за данни с висока производителност.

- ETL и оркестрация на данни:

- Apache Airflow – за планиране и автоматизация на ETL процеси.

- dbt (Data Build Tool) – за трансформация и управление на аналитични данни.

- Talend и Fivetran – инструменти за извличане и интеграция на данни.

- Програмиране и анализ:

- Python – най-използваният език за инженерство на данни с библиотеки като Pandas, NumPy и SQLAlchemy.

- Spark и Hadoop – подходящи за обработка на големи масиви данни в разпределени среди.

- Бизнес разузнаване (BI) и анализ:

- Power BI, Tableau, Looker – за визуализация и генериране на отчети.

При избор на стек е важно да се оцени мащабируемостта на решенията и интеграцията с вече съществуващите платформи.

Автоматизация и оптимизация на ETL процесите

ETL (Extract, Transform, Load) процесите са гръбнакът на инженерството на данни, а тяхната автоматизация значително повишава ефективността и надеждността на данните. Следните стъпки са ключови за оптимизиране на ETL процесите:

- Използване на оркестрационни инструменти:

- Apache Airflow за автоматично стартиране на ETL задачи.

- Prefect за управление на ETL процеси в облачни среди.

- Оптимизиране на трансформациите:

- Използване на инкрементални трансформации, които обработват само новите или променени данни, вместо целия набор.

- Внедряване на паралелна обработка, за да се намали времето за изпълнение на ETL процесите.

- Мониторинг и наблюдение на процесите:

- Логване на грешки и събития с помощта на инструменти като ELK Stack (Elasticsearch, Logstash, Kibana).

- Настройване на известия при неуспешни задачи чрез Slack, PagerDuty или e-mail интеграции.

- Използване на облачни решения:

- Amazon Glue, Google Dataflow и Azure Data Factory за автоматизиране на ETL в мащабируеми облачни среди.

Пример: Една компания може да автоматизира обработката на клиентски транзакции, като извлича данни от SQL база, трансформира ги с Apache Spark и ги съхранява в облачен склад за данни, като Snowflake или Google BigQuery.

Интегриране на различни инструменти за по-ефективно управление на данните

Въпреки че отделните инструменти предлагат мощни възможности, истинската ефективност идва от тяхната интеграция в единна среда. Основните стратегии за интегриране на технологии за инженерство на данни включват:

- Свързване на ETL процесите със складовете за данни:

- Комбиниране на BI инструменти с платформи за данни:

- Интеграция между Tableau и Google BigQuery за създаване на визуални отчети върху реални бизнес данни.

- Microsoft Power BI може да извлича данни директно от Azure Data Lake или SQL Server за интерактивни анализи.

- Прилагане на DevOps и CI/CD за инженерството на данни:

- Автоматизиране на деплоймънтите с Terraform или Kubernetes.

- Използване на GitHub Actions или Jenkins за автоматично тестване на ETL скриптове.

- Гарантиране на сигурност и управление на достъпа:

- Настройване на ролеви модели за достъп (RBAC), които контролират кой може да чете, модифицира или изтрива данни.

- Използване на Data Catalogs (като Alation или Collibra) за централизирано управление на данните.

Пример: Глобална компания използва Apache Airflow за координация на ETL процеси, Google BigQuery като централен склад за данни, а Looker за интерактивни визуализации. Всички тези компоненти са свързани, така че бизнес анализаторите получават актуални данни в реално време.

Планирането и изпълнението на успешна стратегия за инженерство на данни изисква интегриран подход, който съчетава правилните технологии, автоматизация и ефективно управление. Изборът на подходящ технологичен стек, оптимизацията на ETL процесите и безпроблемната интеграция между различни инструменти са от съществено значение за изграждане на надеждна и мащабируема инфраструктура за данни.

В следващата част ще обобщим ключовите концепции, разгледани в статията, и ще подчертаем как организациите могат да използват инженерството на данни за оптимизиране на своите бизнес процеси.

Заключение

В свят, управляван от информация, инженерството на данни играе ключова роля за ефективното използване на корпоративните ресурси и вземането на стратегически решения. В тази статия разгледахме основните концепции, свързани с обработката на данни, включително използването на SQL за работа с бази данни, Python за автоматизация на ETL процеси, Apache Airflow за оркестрация, както и изграждането и управлението на складове за данни. Освен техническите аспекти, подчертахме и значението на добрите практики в управлението на данните (Data Governance), които гарантират тяхната сигурност, точност и достъпност.

Компаниите, които инвестират в правилните технологии и стратегии за управление на данните, изграждат солидна основа за устойчив растеж и иновации. Независимо от мащаба на бизнеса, прилагането на добри практики като автоматизация на процесите, интегриране на BI инструменти и внедряване на политики за защита на информацията води до по-ефективно вземане на решения и конкурентно предимство. Инженерството на данни не е просто технологична тенденция – то е съществен фактор за дигиталната трансформация на организациите.

Русенската търговско-индустриална камара се стреми да бъде надежден партньор за бизнеса, осигурявайки достъп до обучения, практически ресурси и експертни насоки в сферата на данните и технологиите. Със съвременните предизвикателства, пред които компаниите се изправят, Камарата подпомага организациите в изграждането на компетентности, които ще им помогнат да се адаптират към новите реалности и да използват данните като стратегически актив.

Използването на инженерството на данни не е просто въпрос на технология – това е начин на мислене, който помага на компаниите да изградят устойчиви и ефективни процеси. Време е организациите да се възползват от възможностите, които съвременните технологии предлагат, за да оптимизират своите операции и да изградят бъдещето си върху стабилна основа от данни и аналитика.

Забележка: Публикацията е изготвена с помощта на генеративен изкуствен интелект, който подпомогна структуриране и формулиране на съдържанието. Финалният текст е резултат от експертния принос на автора, който гарантира неговата точност и практическа насоченост.